今回はvsphere with tanzuのworkerノードへのディスク追加方法についてご紹介します。

コンテナは軽量という印象をお持ちの人も多いと思いますが、コンテナイメージによっては数GBのサイズがあったりで意外とサイズの大きいものもあります。

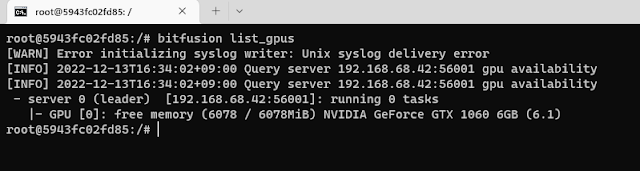

私はAI系のコンテナイメージを利用することが多いのですが、これがイメージサイズが大きくてpull imageで時間がかることがあります。時間がかかるだけであればいいのですが、ディスクサイズに収まらないということも発生します。

通常のKubernetesやDockerであればホストOSのディスクサイズは仮想マシンでも数十GBから数百GB程度取ることがあるのであまり問題はないのですが、TanzuでTKCを作成してWoker Nodeを展開すると私の環境の場合はディスクサイズが16GBで、Workerノードのディスク容量が足りずにコンテナイメージを展開できないことがありました。

状況としてはkubetctl get pod でStatusがEvictedになります。

kubectl describe podで詳細を確認すると、The node was low on resource: ephemeral-storage.のメッセージが、、、

色々ためしたのですがWorkerノードのディスクを拡張するしかなく、tkcを作成するyamlファイルに以下を追加することで回避できました。

volumes:

- name: containerd

mountPath: /var/lib/containerd

capacity:

storage: 64GiB

ネット探してもこのあたりに困っている人は少なそうだったんですが、Workerノードのディスクサイズに困っている人は少ないのか、周知の事実なのか、、、

とりあえず、やっとコンテナ使えるようになりました。